Селфи-диагностика. 9 цифровых инструментов для контроля здоровья по лицу

Представьте себе - вы чувствуете себя больным, но вместо того, чтобы идти к врачу, вы достаете свой смартфон и определяете диагноз, сделав селфи. Фантастика? Скорее всего, это скоро станет фактом: ученые уже разработали несколько решений и компьютерных моделей, которые способны точно предсказывает состояние здоровье, основываясь на форме вашего лица, цвете кожи, состоянии глаз, даже на выражении вашего лица. При этом компьютерная модель работает примерно также, как человеческий мозг - не даром существуют люди, которые способны определять наличие определенных заболеваний просто взглянув на лицо своего собеседника.

Лицо содержит достоверные, ощутимые сигналы о состоянии физиологического здоровья человека и компьютерная модель распознавания лиц может точно предсказать индекс массы тела, содержание жира, состояние кожи и данные артериального давления, показывают новые исследования.

Давайте рассмотрим несколько подобных решений.

Мониторинг давления крови

Недавно опубликованные в журнале Circulation данные исследования свидетельствуют, что измерение артериального давления с помощью смартфона, использующего технологию трансдермальной оптической визуализации, позволило с высокой точностью прогнозировать систолическое и диастолическое кровяное давление.

Технология, использованная в исследовании, основана на применении алгоритмов машинного обучения и визуализации кровотока с видеоизображений лица с помощью камеры смартфона.

Исследователи обнаружили, что модель смогла предсказать систолическое артериальное давление с точностью 94.81%, а диастолическое - с точностью 95.7%, т.е. технология способна предсказывать артериальное давление в пределах "клинически приемлемого порога точности 5 ± 8 мм рт.ст. при проведении испытаний на всем диапазоне артериального давления".

Ученые отметили, что исследование проводилось в хорошо контролируемой среде с фиксированным освещением, что, по мнению исследователей, является ключевым ограничением в их работе.

Решение пока не оформлено в виде приложения или другого какого-либо программного продукта.

Похожее решение разработали исследователи из университета Торонто в Канаде и филиала больницы университета Ханчжоу в Китае. На днях они опубликовали доказательство того, что приложение для смартфона, снимающее короткое видео, может точно определять артериальное давление - по крайней мере, у определенных категорий пользователей.

Их решение также использует технологию трансдермальной оптической визуализации. Свет, излучаемый камерами смартфона, отражается от белков, находящихся вблизи поверхности кожи, с разной скоростью. Измеряя мельчайшие изменения гемоглобина - 900 снимков, сделанных за 30 секунд - можно получить показания артериального давления. Система использует алгоритм машинного обучения, который позволял получать показания артериального давления с точностью до 95%. По крайней мере, для людей, которые участвовали в исследовании - выходцев из Восточной Азии или Европы.

Отметим, что приложение для смартфона Anura еще не готово к использованию. Оно доступно в магазинах приложений для iOS и Android бесплатно, но в ее нынешнем виде она определяет только сердечный ритм и уровень стресса у пользователей.

Мониторинг хронических заболеваний

Группа разработчиков из семи европейских стран создали решение, получившее название Wize Mirror и похожее на обычное зеркало, но включает в себя 3D-сканнер, мультиспектральные камеры и газовые сенсоры, позволяющие оценить здоровье человека, смотрящего на свое отражение. Устройство делает это, оценивая лицо человека, его жировую ткань, мимику и цвет кожи.

Группа разработчиков из семи европейских стран создали решение, получившее название Wize Mirror и похожее на обычное зеркало, но включает в себя 3D-сканнер, мультиспектральные камеры и газовые сенсоры, позволяющие оценить здоровье человека, смотрящего на свое отражение. Устройство делает это, оценивая лицо человека, его жировую ткань, мимику и цвет кожи.

Wize Mirror предназначено? в первую очередь, для людей с хроническими болезнями, такими как диабет и сердечные заболевания.

Система ищет явные признаки стресса и тревожности, газовые сенсоры берут образцы выдыхаемого пользователем воздуха, чтобы определить содержание компонентов, показывающих, как много он курит или пьет. Трехмерный сканер анализирует форму лица, чтобы зафиксировать набор или потерю веса, в то время как мультиспектральные камеры помогают оценить частоту биения сердца и уровень гемоглобина. После того, как программное обеспечение проанализирует лицо, а занимает это всего около минуты, зеркало выдает результирующие значения, которые отображают уровень здоровья пользователя.

Правда, пока существуют проблемы обеспечения точности измерений из-за множества меняющихся параметров, таких как освещение, чрезмерная подвижность пользователя и т.п.

Мониторинг сердечного ритма

Приложение с незамысловатым названием Heart Rate позволяет измерить частоту сердечного ритма путем направления камеры смартфона на ваше лицо. Просто держите смартфон перед своим лицом, центрируя его расположение, ориентируясь на изображение на экране. Показанная на экране иконка станет зеленой, когда вы правильно расположите смартфон.

Тесты показывают, что измерения с помощью фронтальной камеры практически также точны, как и замеры при помощи вашего пальца и задней камеры, что уже используются в некоторых мобильных приложениях. Все что нужно, это быть в хорошо освещенном месте, а также не дергаться и не разговаривать при измерениях.

Программа позволяет также просматривать данные за определенный период времени, в том числе и в графическом виде.

Приложение существует только в версии для iOS и стоит оно меньше $1.

Контроль психического здоровья

Исследователи из университета Карнеги-Меллона разработали решение на базе алгоритмов машинного обучения для анализа мимики лица, основываясь на 68 его различных точках, включая брови, уголки глаз, рот и нос. Система получила название MultiSense и используется для отслеживания связей между лицевой мимикой и эмоциональным состоянием людей, страдающих от депрессии. Новая технология может помочь врачу постоянно и незаметно контролировать состояние здоровья своих пациентов и делать это, используя объективные количественные данные.

Система может также в реальном времени отслеживать положение головы человека, направление его взгляда и ориентацию его тела. Такой уровень детализации может дать на удивление много информации. Взглянув на нос человека и его брови, мы можем отличить, например, счастливую улыбку от злой усмешки, или от улыбки, вызванной ситуацией, а не эмоцией.

Разработчики при этом отмечают, что такой инструмент больше подходит для постоянного лечения пациентов, страдающих от депрессии, а не для диагностики болезни.

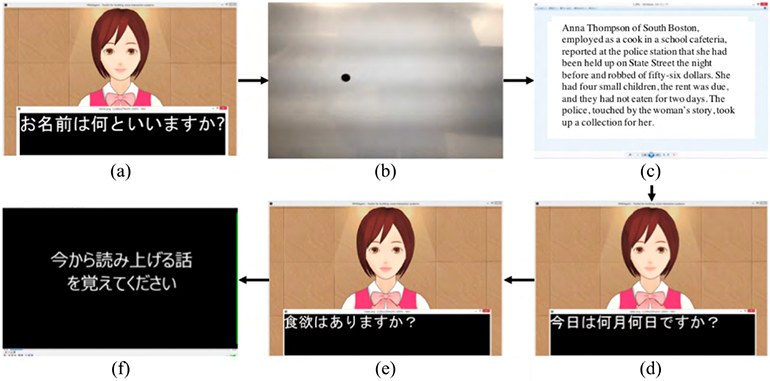

Японские исследователи из университета в Осаке и Института науки и технологии в Наре разработали метод диагностирования деменции, который использует анализ ответов пациентов на специализированные вопросы и их реакций при этом. Программное обеспечение идентифицирует различные параметры речи, такие как тон, скорость интонацию, а также употребление глаголов и существительных. В это же время программа с помощью камеры отслеживает выражение лица пациента и измеряет ряд визуальных параметров. Информация об этом проекте была опубликована в IEEE Journal of Translational Engineering in Health and Medicine.

Вся эта информация обрабатывается с помощью алгоритмов машинного обучения, которые ранее уже были "натренированы" на данных людей, как страдающих от деменции, так и тех, кто только проявляет признаки заболевания или здоров. При тестировании системы программа показала 90%-точность, основываясь лишь на 6 вопросах, ответ на каждый из которых занимал только две - три минуты.

Распознавание эмоций

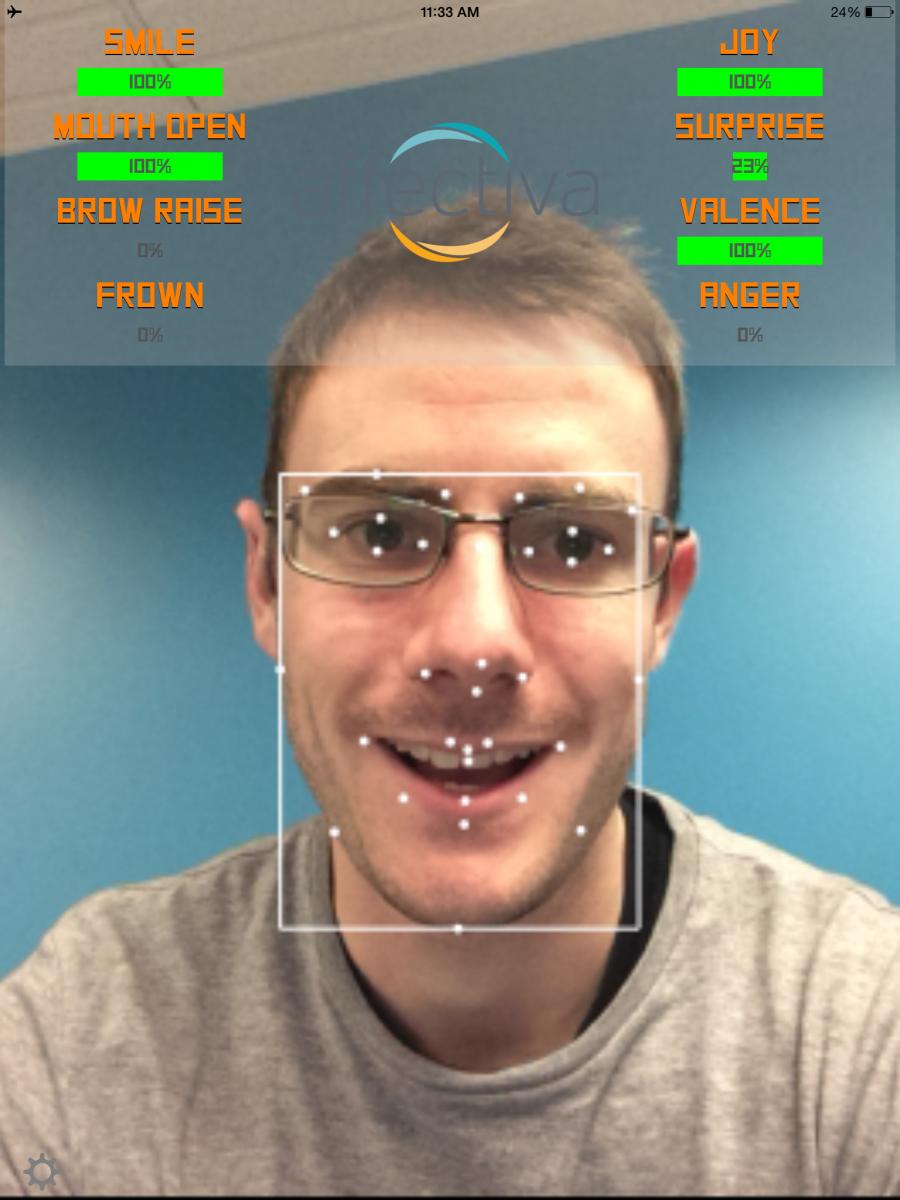

Новая технология распознавания эмоций Affectiva использует камеру ноутбука, планшета или смартфона для того, чтобы расшифровать лицевые сигналы. Алгоритм программы считывает эту информацию, чтобы определить эмоции, которые в данный момент испытывает пациент. Это может быть особенно полезным в телемедицине, где врач ведет общение с пациентом с помощью мобильной видео-платформы. Возможность для доктора распознать, как себя чувствует пациент, может пригодиться в лечебном процессе.

Система может помочь ответить на ряд вопросов, начиная от определения, работает ли конкретная терапия, и заканчивая выяснением отношения клиентов к конкретной кампании и насколько это отношение совпадает с ожидаемым.

Исследователи из Affectiva, в частности анализируют вариативность сердечного ритма на основе данных видео лица, что позволяет более точно оценивать эмоции человека. Этот подход, кстати, показал улучшенные возможности оценки частоты сердечных сокращений по сравнению с существующими современными технологиями и может оказаться актуальным для тех, кто заинтересован в измерениях краткосрочных колебаниях частоты сердечных сокращений.

Алгоритм Affectiva считывает действующие элементы лица, например, форму губ при улыбке или бороздки у бровей, и генерирует тип эмоции, основываясь на данных 12 млрд. эмоциональных точек, полученных из 2,9 млн видео лиц из 75 стран мира.

Диагностика

Диагностика аутизма

Компания RightEye разработала облачную программную систему отслеживания движения глаз пользователя, на базе которой создала два медицинских теста. Один из них позволяет врачам быстро идентифицировать у детей в возрасте 12 - 40 месяцев первые признаки аутизма, а второй предназначен для диагностики болезни Паркинсона у пациентов любого возраста.

Компания RightEye разработала облачную программную систему отслеживания движения глаз пользователя, на базе которой создала два медицинских теста. Один из них позволяет врачам быстро идентифицировать у детей в возрасте 12 - 40 месяцев первые признаки аутизма, а второй предназначен для диагностики болезни Паркинсона у пациентов любого возраста.

Программное обеспечение RightEye работает за счет отслеживания движений глаз, когда пациенту показывают видео на планшете. Устройство, контролирующее движения глаз, устанавливается внизу на большом игровом планшете, а все данные, измеренные трекером глаз, тут же интерпретируются программным обеспечением, после чего генерируется отчет, который отправляется врачу. Тест продолжается несколько минут и каждый сценарий требует от пациентов следить за графикой на экране.

Новые тесты позволят существенно быстрее получать результаты и диагностировать заболевание, чем современные методы, которые требуют многочисленных посещений врача, большого количества бумажной работы и массы тестов.

Диагностика заболеваний кожи

Приложение Sunface ставит своей целью предотвратить избыточное пребывание на солнце, получение солнечных ожогов заболевание раком кожи. Основная целевая аудитория этого продукта - молодежь.

Это приложение позволяет пользователю сделать селфи и затем предлагает выбор из трех категорий - "дневная защита от солнца", "без солнцезащиты" и "еженедельное времяпровождение на шезлонге". После этого программа предлагает пользователю взглянуть на свое лицо, каким оно будет через 5 - 25 лет. Все эффекты, отображающиеся при этом, основаны на индивидуальном типе кожи, который пользователь может выбрать в начале использования приложения. Кроме этого, система имеет несколько кнопок, позволяющих показывать наиболее частые виды рака кожи, связанные с ультрафиолетовым облучением, и рассчитывает, насколько увеличивается риск заболевания в зависимости от поведения человека. Приложение также рассказывает о методах самодиагностики рака кожи.

Определение редких генетических заболеваний

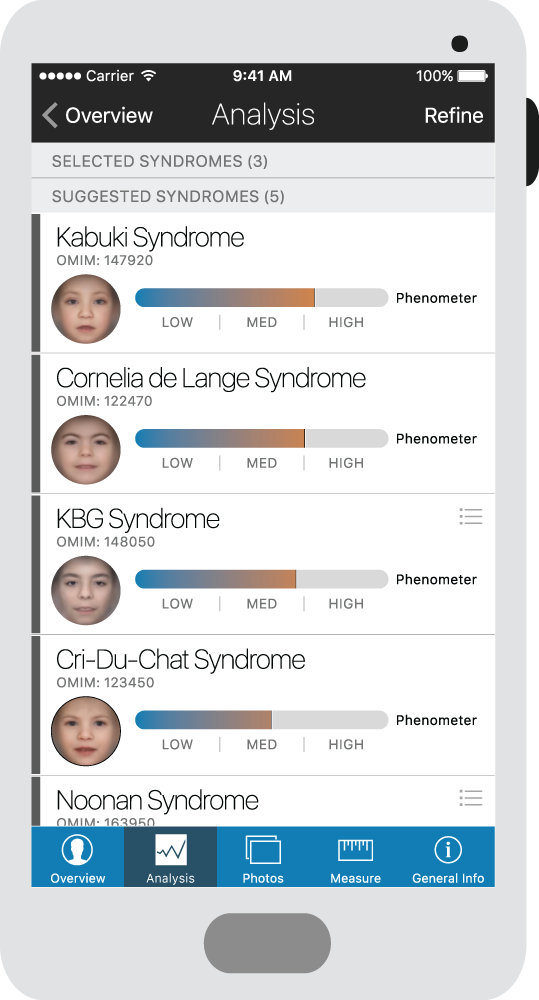

Набор алгоритмов анализа изображений, разработанных американским стартапом FDNA, может диагностировать определенные генетические заболевания на основе анализа фотографии лица человека. Этот программный пакет, названный DeepGestalt, основан на алгоритмах глубокого обучения и компьютерного зрения, которые идентифицируют закономерности на фотографиях лиц пациентов и определения того, какая из множества возможных генетических мутаций может быть у этого человека.

Алгоритмы обеспечивают точность 64%, что значительно лучше, чем у врачей, которые, по данным исследования 2010 года, не могут идентифицировать мутацию только по фенотипу лица.

Алгоритмы обеспечивают точность 64%, что значительно лучше, чем у врачей, которые, по данным исследования 2010 года, не могут идентифицировать мутацию только по фенотипу лица.

Алгоритмы DeepGestalt включены в приложение компании Face2Gene, которое свободно распространяется среди медицинских профессионалов. Врачи уже начали использовать эту технологию в качестве вспомогательного средства, хотя, как оговариваются представители компании, этот инструмент не предназначен для постановки окончательного диагноза.

Общее число болезней, которые сегодня умеет диагностировать DeepGestalt составляет 216.

Аналогичное приложение было разработано американскими учеными из Института детской хирургии имени Шейха Зайеда. В этом продукте используется цифровое программное обеспечение для анализа лица, позволяющее определить у ребенка наличие генетического заболевания - синдрома Ди Джорджи, характеризующегося многочисленными пороками развития.

Это приложение на основе 126 индивидуальных черт лица они смогли правильно диагностировать заболевание с точностью 96,6% и выше у пациентов из практически каждой этнической группы.

Эта же технология была также очень точной в диагностике синдрома Дауна.

Контроль лежачих пациентов

Технология распознавания лиц может быть использована для мониторинга пациентов под седативными препаратами в отделениях интенсивной терапии, предупреждая медицинских работников, когда пациент рискует случайно вынуть дыхательную трубку или совершить другие рискованные действия. Концепция была проверена с умеренным уровнем точности (75 %) в японском исследовании, в котором использовался алгоритм, обученный на основе анализа изображений с камер, направленных на лица 24 пациентов в отделении интенсивной терапии.

После анализа данных, ученые из Йокогамского городского университета (Япония) создали свой инструмент для распознавания признаков изменения мимики лица, движения глаз и рук, связанные с повышенным риском.

В настоящее время японские исследователи дорабатывают свое решение, чтобы оно могло работать с пациентами, находящимися в разных позициях, чтобы сделать инструмент универсальным для повседневной работы в отделении интенсивной терапии.